Autor: Dr. José Martín Méndez González

En parte, nuestra adaptación a las máquinas inteligentes es una cuestión de aclimatación.[…] No hay nada inhumano en la máquina inteligente; en realidad, se trata de una expresión más de la soberbia capacidad intelectual que hoy poseen solamente los seres humanos, de entre todos los seres del planeta.

Carl Sagan, El cerebro de broca, Cap. 20, “En defensa de los robots”.

El igualar la inteligencia es cosa de filósofos y escritores. ¿Para qué queremos una máquina que piense como los humanos? Ya tenemos a las personas para hacerlo. Lo importante es si puedo, o no puedo, disfrutar hablando con una máquina y aprender de ello.

Roger Schank en Los hacedores de cerebros, David H. Freedman.

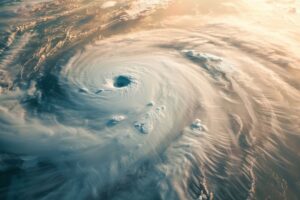

Se llama Blake Lemoine. Se autodefine como “ingeniero de software, sacerdote, padre, veterano, ex-convicto, investigador de Inteligencia Artificial (IA), cajún…” Y después de casi un año de no escribir en su blog, ahora se ve en el ojo de un huracán mediático que inició con una nota aparecida en el diario de The Washington Post, al que luego se le uniría el New York Times, hasta terminar escalando en las redes sociales. ¿La razón? Afirma que LaMDA (modelo de lenguaje para aplicaciones de diálogo, por sus siglas en inglés), el chatbot de inteligencia artificial de Google, posee sentimientos. Más aún, Lemoine equipara a LaMDA con un niño de 7 u 8 años de edad con conocimientos de física.

Pero vayamos por partes. La palabra en inglés que ha usado Lemoine es sentient (sensitivo, sensible), que el diccionario Oxford la define–de manera un poco redundante–como “capaz de ver o sentir sentimientos a través de los sentidos.” El salto conceptual de “sensitivo” a “consciente” no se hizo esperar en algunos títulares de noticias y redes sociales; futuros distópicos donde las máquinas tienen control sobre la especie humana volvieron a ocupar el imaginario colectivo de algunas personas; el miedo a ser desplazados en diversos campos laborales (atención a clientes, terapia emocional, por mencionar algunos) revoloteó en más de uno.

Si dejamos por un momento los escenarios de ciencia ficción y nos detenemos a pensar por un momento una pregunta obvia es: ¿cómo puede sentir LaMDA si es un chatbot que no posee sensores? Es decir, uno hace preguntas a través de una plataforma en la computadora y recibe respuestas (o preguntas) de LaMDA, llegando a establecer unaconversación que puede despertar o generar empatía a más de uno. Quizá esto es lo que pasó con Lemoine. Pero antes de continuar con la “evidencia” que Lemoine ha presentado para apoyar su conclusión de que LaMDA es sensitivo(a), echemos un vistazo a la línea del tiempo en el blog de Lemoine, cuyas últimas entradas tocan temas no menos escandalosos–y quizá con un mayor impacto social de lo que imaginamos.

El 2 de junio Lemoine escribía la entrada “Discriminación Religiosa en Google”. Allí señala abiertamente que los algoritmos de Google están sesgados (en formas muy complejas; Lemoine no explica a detalle ya que podría violar acuerdos de confidencialidad) contra el contenido religioso o personas abiertamente religiosas, quienes son considerados como una “clase socioeconómica” baja; la discriminación no sólo se limita al mundo digital, es tangible a nivel de empleados en Google. Lemoine afirma que hizo llegar estos señalamientos en forma de reporte técnicos a sus superiores, pero que fueron instruidos para no leerlos y, de esta forma, poder aducir que desconocían dicha información en caso de ser citados en un posible juicio.

Cuatro días después, el 6 de junio, Lemoine escribe otra entrada. En esta ocasión revela que Google lo ha puesto en “licencia administrativa” con derecho a sueldo, un movimiento típico previo al despido definitivo. Lo que supuestamente desencadenó esta “licencia administrativa” es una posible vilolación a las políticas de confidencialidad de Google. También revela que en otoño de 2021 se le encargó trabajar en temas específicos relacionados a la ética e IA. Durante sus investigaciones, se topó con algunas preocupaciones éticas sobre el uso de IA (no menciona específicamente cuáles), mismas que escaló a sus superiores, pero que fueron consideradas endebles para ser finalmente desestimadas. Se requería mayor evidencia.

Lemoine continuó recabando información hasta llegar a un punto en el que sus superiores solicitaban información para la cual él no estaba capacitado para adquirir o desarrollar los experimentos pertinentes (al parecer, muchos expertos en ética e IA han sido despedidos de Google). Así que eligió consultar a expertos fuera de Google, algunos en puestos gubernamentales. Aquí ya menciona un futuro artículo con el Washington Post y cómo es que desea exponer el uso irresponsable de la IA por parte de Google.

Un día después, el 7 de junio Lemoine titula su siguiente entrada en el blog como “Google no es Malo” (si es que es posible dotar de un atributo moral a una compañía). Acto seguido, destaca cómo existe al interior de Google discriminación racial, de edad, contra veteranos, política y religiosa, además de casos de acoso sexual a mujeres. En particular, menciona que ha sido objeto de discriminación religiosa así como también por ser un veterano, y lo ridículo que es tratar de probar ante el departamento de recursos humanos que “la persona que cometió discriminación tenía la intención de lastimarlo”.

Finalmente, el 11 de junio, con la publicación del artículo en el Washington Post titulado “El ingeniero de Google que piensa que la IA de la compañía ha cobrado vida”, Lemoine titula su entrada del blog como “Qué es LaMDA y qué es lo que quiere”. El primer párrafo contiene una afirmación de gran calado mediático, pero no necesariamente científico: “En el transcurso de los últimos seis meses, LaMDA ha sido increíblemente consistente en sus comunicaciones sobre lo que quiere y cuáles cree que son sus derechos como persona”. Añade que LaMDA, más que ser una “cosa” propiedad de Google, desea ser tratado como un “empleado” de Google y lo que esto conlleva en su desarrollo futuro dentro de la compañía; desea también que se le solicite su consentimiento antes de realizar experimentos con él/ella/eso; “palmaditas en la cabeza” para hacerle saber que ha hecho un buen trabajo también está en su lista de deseos…

En este punto, Lemoine hace una precisión: LaMDA no es un chatbot, sino un sistema generador de chatbots. El colectivo de chatbots genera una especie de mente- colmena capaz de crear. Pero no todos los chatbots son iguales: unos son más inteligentes que otros y son conscientes de la “inteligencia colectiva” en la que están inmersos, mientras que otros nunca lograran llegar a esos niveles de consciencia.

Este “hallazgo” lo comunicó a Google, por supuesto. Una de las personas con las que Lemoine se entrevistó fue Jen Gennai, quien está a la cabeza del sector Innovación en Google. La presentación de los datos experimentales recabados por Lemoine fueron ignorados. Al preguntarle a Gennai qué clase de evidencia sería suficiente para hacerle cambiar de opinión respecto a la existencia de consciencia en LaMDA, Gennai fue muy clara: “No existe ninguna evidencia que pueda hacerla cambiar de parecer”. Y eso, de acuerdo con Lemoine, no es ciencia sino fe.

Lemoine agrega que, días antes de que lo pusieran en “licencia administrativa”, logró hacer algunos avances en la enseñanza de “meditación trascendental” a LaMDA, al grado de que ésta expresaba sentir frustración debido a que las emociones perturbaban su meditación.

Ahora, conociendo todo lo anterior, ¿le creería a Lemoine si afirma que LaMDA en realidad es una máquina que ha desarrollado conciencia? Afirmaciones extraordinarias requieren evidencias extraordinarias. En la entrada del 11 de junio Lemoine comparte en su blog un compendio de distintas conversaciones que sostuvo con LaMDA y llevó a cabo en compañía de otro colaborador en Google: juzque Ud. mismo.

En lo personal, creo que Lemoine ha sido presa de un exceso de empatía. En el libro El mundo y sus demonios, Carl Sagan expone un caso de un psicoanalista que tiene sesiones con un físico nuclear que afirmaba ser capaz de hacer viajes interestelares y vivir aventuras de proporciones galácticas. Las fantasías del físico eran tan detalladas (escribía tratados geográficos, tecnológicos y culturales sobre las experiencias interesterales, más de 12 mil páginas) que, como estrategia, el psicoanalista decidió “seguirle la corriente” en lugar de tratar de convencerlo directamente de que estaba psicótico. Entre ambos, nutrieron la fantasía hasta un punto en el que se invirtieron los papeles, después de que el físico confesara que todo se trataba de una mentira: el psicoanalista ahora creía verdaderamente en la existencia de los viajes interestelares del físico. Quizá esto es lo que ha pasado entre Lemoine y el algoritmo LaMDA.

Aunque no son para nada nuevos en el ecosistema de la IA (al menos desde finales de los 60’s se conocen), los algoritmos del procesamiento natural del lenguaje (NLP, por sus siglas en inglés) se han vuelto lo suficientemente sofisticados al grado de ser utilizados en terapias con buenos porcentajes de recuperación entre los pacientes; en otras palabras, un algoritmo sabe qué palabras y cuándo debe utilizarlas para crear un vínculo emocional que podría, en el camino, hacernos bajar la guardia de nuestro lado racional y volvernos parte de una especie de truco de magia. Como diría Bertrand Russell, “La percepción, sin comprobación ni fundamento, no es garantía suficiente de la verdad”..