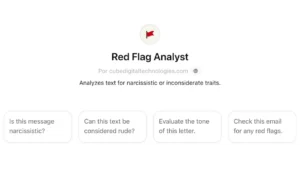

Una herramienta para identificar señales de alerta

La inteligencia artificial sigue avanzando y ahora ofrece una herramienta que genera gran controversia: ChatGPT ha incorporado la función “Red Flag Analyst”, diseñada para analizar conversaciones y detectar “red flags” o señales de alerta en las interacciones personales. Esta función ha captado la atención de usuarios en redes sociales, quienes comparten videos en los que ponen a prueba su eficacia. La herramienta promete detectar rasgos de comportamiento como el narcisismo, la falta de consideración y tonos de lenguaje potencialmente problemáticos en los mensajes. Esto plantea interrogantes sobre la privacidad y la dependencia de la tecnología para gestionar relaciones interpersonales.

Cómo funciona el “Red Flag Analyst” de ChatGPT

Para utilizar esta función, los usuarios ingresan al menú de ChatGPT y seleccionan “Red Flag Analyst”, que permite analizar textos en búsqueda de comportamientos problemáticos. La IA señala que puede realizar varias tareas, entre ellas:

•Identificar mensajes narcisistas.

•Detectar lenguaje grosero o despectivo.

•Evaluar el tono en una carta o mensaje.

•Revisar un mensaje completo para identificar red flags.

Al cargar una conversación o mensaje en esta herramienta, ChatGPT desglosa los aspectos potencialmente problemáticos. Como ejemplo, algunos usuarios han utilizado diálogos de películas, como una escena de “Historia de un matrimonio”, para probar la función. En esta escena, ChatGPT señala elementos como el tono acusatorio y la falta de respeto por la autonomía del destinatario, subrayando frases que indican intentos de control y lenguaje degradante.

Ejemplo práctico: el análisis de una conversación

En el diálogo seleccionado de “Historia de un matrimonio”, ChatGPT analiza una frase del personaje Charly que dice: “Nunca serás feliz, ni aquí ni en ningún otro lado”. La IA destaca este comentario como presuntuoso y controlador, dado que implica que una persona puede predecir el bienestar futuro de otra, restando autonomía y respeto. Otro aspecto que detecta es el lenguaje culpabilizador en la expresión “quieres quejarte por no tener una p*ta voz”, que ChatGPT califica como un tono emocionalmente manipulador. La herramienta, en este caso, alerta sobre una posible dinámica tóxica y sugiere la importancia de establecer límites para proteger el bienestar emocional.

Opiniones divididas: ¿es seguro confiar en una IA para detectar problemas de relación?

La popularidad de esta función ha generado opiniones divididas entre los usuarios y expertos en salud mental. Algunos consideran útil la posibilidad de contar con un análisis rápido de una IA para encontrar señales de advertencia en las interacciones, lo cual puede ser un apoyo preliminar en momentos de duda. Sin embargo, otras voces advierten sobre los riesgos de confiar en una inteligencia artificial para interpretar complejas dinámicas humanas. Para muchos, exponer una relación personal a una herramienta tecnológica representa un dilema, especialmente en términos de privacidad.

La psicóloga María Elena Daprá, consultada por el diario El País, afirma que el uso de IA en este contexto sugiere que la persona que recurre a ella ya percibe un problema en su relación. Daprá señala que sería más beneficioso explorar de manera directa esos sentimientos, en lugar de buscar respuestas en una máquina. Asimismo, algunos usuarios ven la ironía en el hecho de recurrir a la IA como una señal de alerta en sí misma, indicando que depender de una herramienta de este tipo podría ser una “red flag” adicional.

Consideraciones sobre privacidad y salud emocional

El uso de “Red Flag Analyst” implica compartir conversaciones completas con una IA, lo que podría representar un riesgo en términos de confidencialidad. Aunque ChatGPT asegura manejar la información de forma segura, la naturaleza de la herramienta ha llevado a algunos usuarios a cuestionar si es prudente subir textos sensibles. Además, la función genera preguntas sobre la dependencia emocional en herramientas digitales para evaluar las relaciones. Algunas personas consideran que analizar la dinámica con una IA puede reducir la autoexploración y la capacidad de enfrentar problemas de manera directa con la pareja o con ayuda profesional.

Para otros, la herramienta ofrece un enfoque innovador y potencialmente útil para detectar patrones nocivos que pueden pasar desapercibidos en las interacciones cotidianas. La función, si se usa con precaución, puede dar una perspectiva objetiva sobre aspectos puntuales, aunque los expertos subrayan que no debe ser un sustituto del juicio propio o de la orientación profesional.

La IA en un papel delicado dentro de las relaciones

La incorporación de esta función en ChatGPT representa un paso más en el desarrollo de la IA para aplicaciones personales, pero también deja en evidencia la complejidad de las relaciones humanas y los límites de la tecnología en el ámbito emocional. La posibilidad de analizar mensajes para detectar “red flags” es solo un ejemplo de cómo la IA comienza a desempeñar un papel en áreas que hasta ahora habían sido exclusivas del análisis humano.

Aunque “Red Flag Analyst” tiene el potencial de alertar sobre comportamientos tóxicos en las relaciones, la función también plantea preguntas importantes sobre la privacidad y la necesidad de equilibrar la tecnología con el sentido común y el apoyo humano en asuntos de relaciones interpersonales.