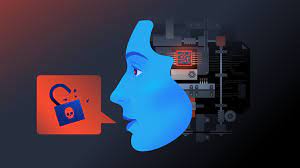

Las amenazas digitales evolucionan constantemente, y una de las más preocupantes en la actualidad involucra la clonación de voces

Esta técnica, difícil de descubrir, se utiliza para engañar a personas, robar información personal y extorsionar a víctimas desprevenidas.

Un ejemplo impactante de esta nueva forma de extorsión involucra a Jennifer DeStefano, quien experimentó el peor tipo de llamada que una madre podría recibir. Una voz que parecía ser la de su hija de 15 años, que estaba de viaje con amigas para esquiar, anunció que había sido secuestrada y suplicaba ayuda.

La voz del supuesto secuestrador advertía a Jennifer que si llamaba a la policía, se tomarían represalias y se llevarían a su hija a México. Además, exigía un rescate de un millón de dólares.

Después de la llamada, Jennifer intentó desesperadamente comunicarse con su hija, solo para descubrir que estaba sana y salva esquiando con normalidad. El incidente resultó ser una extorsión aterradora que utilizó la clonación de la voz de la hija, generada por software impulsado por inteligencia artificial. La precisión y autenticidad de esta voz clonada engañaron a Jennifer durante unos angustiosos cuatro minutos.

Este caso no es un incidente aislado; ha habido múltiples casos de extorsiones similares en Estados Unidos y América Latina. Esta alarmante tendencia ha llevado a las autoridades a considerar la necesidad de legislación que aborde específicamente el uso de esta tecnología en actividades delictivas.

Aún no hay regularización de la IA en América Latina

Quizás no exista un ciberdelito que se beneficie más de la inteligencia artificial que el robo de identidad, un acto en el que los delincuentes intentan imitar a terceros para afectar a personas cercanas a la persona suplantada. ¿El método principal? La clonación de voces para simular escenarios de secuestro o circunstancias apremiantes.

Esta estafa se originó en Estados Unidos y alcanzó su punto más alto de casos en 2022, con 5.000 víctimas de extorsión que pagaron 8,8 millones de dólares a delincuentes, según la Comisión Federal de Comercio (FTC) Americano.

Mientras tanto, en América Latina, las empresas tecnológicas desarrollan y lanzan al mercado general aplicaciones y programas capaces de clonar voces sin ninguna regulación que impida el mal uso de estas herramientas. No existe ningún precedente legal que dé rienda suelta a cometer fraude con IA.

En diferentes países se han implementado estrategias y capacitaciones para que los profesionales puedan prevenir estos delitos, o al menos, enseñar a la población a reconocer las técnicas utilizadas por los ciberdelincuentes. Según un informe del Banco Interamericano de Desarrollo (BID) y la Organización de Estados Americanos (OEA), los países que más destacan son:

- Uruguay

- Chile

- Argentina

- México

- Colombia

- Costa Rica

- Paraguay

- República Dominicana

- Trinidad y Tobago

Sin embargo, la falta de leyes que atiendan integralmente estos delitos es una constante, ya que sólo se castigan los casos de suplantación de identidad donde no aparece la clonación de voz.

Los deepfakes de voz aumentan en Estados Unidos

El caso de Jennifer fue muy similar al vivido por Clive Kabatznik, quien llamó a un empleado del Bank of America para resolver algunos problemas con una transferencia bancaria.

Apenas terminó la conversación, Kabatznik contactó nuevamente al empleado del banco, quien sospechosamente le pidió retirar todo el dinero de una cuenta para transferirlo a otra. En esos minutos, los ciberdelincuentes habían clonado la voz de Kabatznik para llevar a cabo la estafa.

Una de las entidades más importantes dedicadas a monitorear el tráfico de audio de los bancos en Estados Unidos, llamada Pindrop, señala que desde este año se ha producido un aumento en el fraude de suplantación de identidad debido a la clonación de voz. Según estudios de la firma de ciberseguridad, de 5 mil millones de llamadas realizadas a bancos:

- Entre 1.000 y 10.000 fueron intentos de estafa, informó Los New York Times.

¿Cuál es el principal objetivo de los delincuentes? Los call center que atienden Tarjetas de crédito. El experto aclaró que si bien la clonación de voz con IA no abunda en estos casos, su potencial aún representa un peligro para la población, ya que no todos los operadores están preparados para distinguir estas estafas.

Los programas más famosos para clonar voces

Entre los productos utilizados para clonar la voz, destacan casos de InclusoLabs, Loro y VALLE. Estos últimos podrían incluso imitar la forma en que las personas expresan sus emociones a través de sus voces.

Por lo tanto, VALL-E es una de las herramientas con mayor probabilidad de ser implementada en estafas, debido a su facilidad de uso y los precios accesibles de su software. ¿Lo más inquietante? VALL-E sólo necesita 3 segundos de muestras de audio para clonar la voz de una persona.

Aunque se han creado software para detectar la clonación de voz, es un campo que se seguirá renovando constantemente y donde las medidas de hoy serán ineficaces mañana, por lo que la mejor instrucción para evitar estos fraudes es mantenerse informado de las principales señales y tener siempre protocolos. reaccionar ante una situación de este tipo.