Algunos sistemas que utilizan la inteligencia artificial (IA) podrían ser discriminatorios o amenazar algunas libertades, advirtió hoy la alta comisionada de la ONU para los derechos humanos, Michelle Bachelet, quien pidió una moratoria en la venta y uso de los que amenazan más gravemente las libertades.

Esta moratoria se debería aplicar en principio para aquellas tecnologías de IA potencialmente discriminatorias o que amenacen nuestros derechos, señaló Bachelet en una intervención ante el Consejo de Derechos Humanos de la ONU, donde hoy también se presenta un informe sobre el impacto de nuevas tecnologías en las libertades fundamentales.

“No podemos seguir reaccionando tardíamente a los efectos de la inteligencia artificial, ni permitir que se use de manera ilimitada, sin fronteras ni supervisión, para enfrentarnos luego a sus casi inevitables consecuencias sobre los derechos humanos”, afirmó la alta comisionada.

Bachelet hizo este llamamiento antes de la presentación de un informe que documenta las amenazas que plantea la IA, tecnología que se define como aquella en la que la máquina puede aprender por sí misma.

El informe ha estudiado el comportamiento de la IA en sistemas de elaboración automática de perfiles, toma de decisiones y otros usos, que, según concluye, pueden vulnerar el derecho a la intimidad y otros relativos a la salud, la educación, la libertad de movimiento o a la libre expresión.

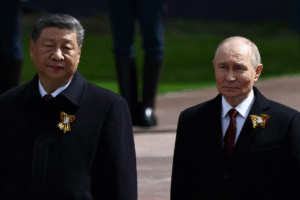

Según el documento, ya ha habido casos en que algunas personas han sido “injustamente tratadas” por el uso de IA, por ejemplo negándoles prestaciones del seguro social o siendo detenidas como consecuencia de errores en los sistemas de reconocimiento facial (muy desarrollados y ya ampliamente usados en China).

El estudio documenta varios aspectos en los que la inteligencia artificial ya está interfiriendo en los derechos humanos, por ejemplo mediante el gran uso de datos personales, algo que pone en riesgo la privacidad de millones de personas.

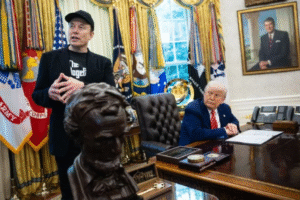

Las grandes multinacionales tecnológicas, dueñas de muchas de esas gigantescas bases de datos, están utilizándolas para determinar mediante inteligencia artificial qué contenido filtrar, cuál amplificar o dejar en un segundo plano, algo que cuanto menos plantea retos frente a la libertad de expresión e información.

Un segundo aspecto es el uso de estos datos de forma discriminatoria, y en este sentido el informe subraya que ya se ha comprobado que algunos sistemas de IA han mostrado sesgos machistas o racistas a la hora de asignar empleos o decidir quién puede o no acceder a determinados servicios sociales.

Además, se han observado tecnologías que usan la IA para influir en el comportamiento de la gente o intentar predecir cuál será en el futuro, señala el informe, que también da la voz de alarma sobre la falta de transparencia en la que se está desarrollando el sector.

No menos preocupante es la utilización de la inteligencia artificial en materia de seguridad, por ejemplo en el control de fronteras o en la identificación de sospechosos, en ocasiones incluso de manera remota, a través de sistemas biométricos como el reconocimiento facial y hasta emocional.

Ante todo ello, Bachelet pidió hoy frenar la utilización de algunas de estas tecnologías “hasta que se haya puesto en vigor las salvaguardas adecuadas”, e incluso prohibir las que ya se determine claramente que suponen una amenaza a los derechos humanos.

“Los datos que alimentan y orientan a los sistemas de IA pueden ser deficientes, discriminatorios, obsoletos o poco pertinentes”, concluye el documento, que señala que estas bases sesgadas “pueden conducir a la adopción de decisiones discriminatorias, un riesgo aún mayor en grupos que ya se encuentran marginados”.